Managed Server S.r.l., azienda specializzata in hosting ad alte prestazioni e soluzioni di sistemistica Linux, ha sviluppato HostingAnalyzer.it, un nuovo software in cloud progettato per analizzare in maniera approfondita le performance di un sito web e valutare l’efficienza dell’infrastruttura di hosting sottostante.

Questo strumento nasce con un obiettivo preciso: offrire agli utenti un sistema semplice, affidabile e trasparente per comprendere le reali capacità del proprio server, andando oltre le semplici promesse commerciali dei provider.

Un software pensato per chi cerca dati concreti, non solo marketing

Nel mercato dell’hosting, spesso è difficile orientarsi. Molti fornitori pubblicizzano prestazioni eccellenti e tempi di caricamento rapidissimi, ma la realtà, nella maggior parte dei casi, è molto diversa.

Managed Server S.r.l. ha sviluppato HostingAnalyzer.it proprio per colmare questo vuoto, fornendo a webmaster, sviluppatori, agenzie e aziende uno strumento professionale che consenta di analizzare i dati reali e comprendere dove si nascondono i veri colli di bottiglia.

Il software consente di valutare parametri tecnici fondamentali per le performance di un sito e fornisce un report chiaro, dettagliato e comprensibile, che permette di individuare con precisione i punti di forza e le aree di miglioramento.

Come funziona HostingAnalyzer.it

HostingAnalyzer.it è un software in cloud accessibile tramite browser: non richiede installazioni, configurazioni complesse o competenze avanzate.

Basta inserire l’indirizzo del sito da analizzare e, in pochi secondi, il sistema esegue una scansione approfondita, restituendo un report completo sui principali indicatori di performance e sulla qualità dell’infrastruttura di hosting.

Tra i parametri analizzati, troviamo:

-

Protocollo utilizzato

Il sistema rileva se il sito opera su HTTP/1.1, HTTP/2 o HTTP/3. Questo dato è cruciale: l’adozione di protocolli moderni consente di sfruttare al meglio le potenzialità delle connessioni e migliorare la velocità di caricamento delle pagine, soprattutto da dispositivi mobili. -

Compressione dei dati

HostingAnalyzer verifica quale metodo di compressione viene utilizzato dal server. Oltre ai classici gzip e Deflate, il tool analizza l’eventuale supporto a tecnologie più moderne, come Brotli o Zstandard, che offrono prestazioni nettamente superiori e una riduzione significativa della banda utilizzata. -

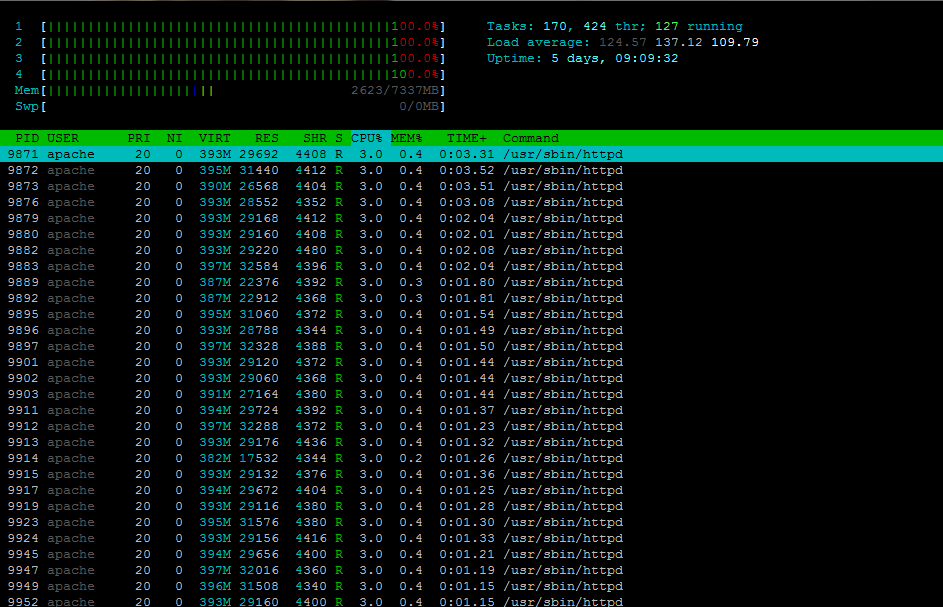

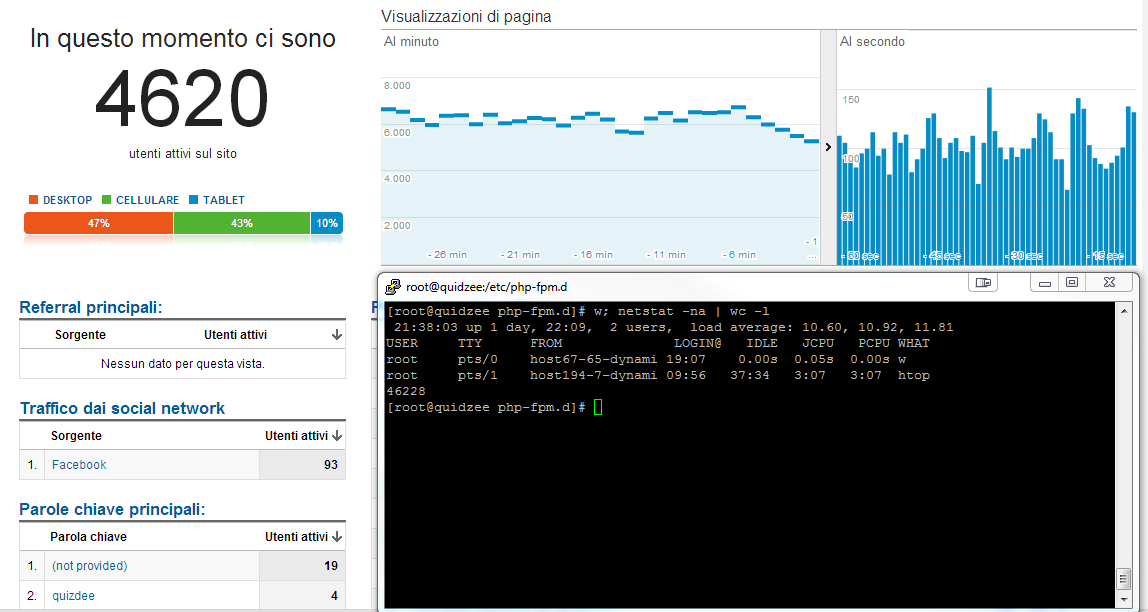

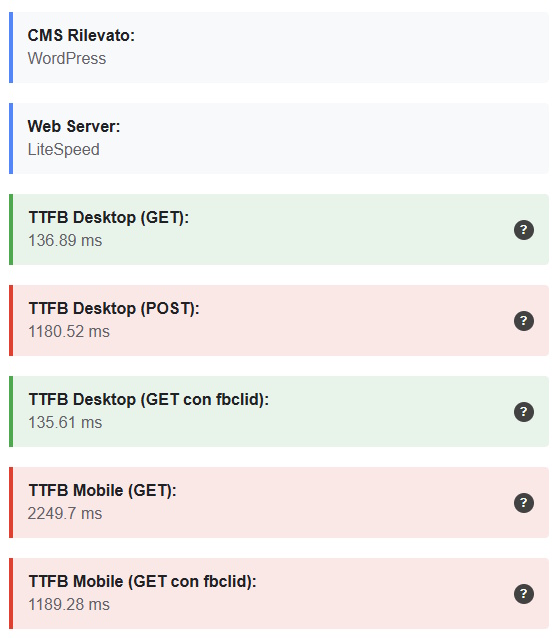

TTFB (Time To First Byte)

Uno dei parametri più importanti per valutare la velocità di risposta di un server. Un TTFB inferiore ai 200 millisecondi è indice di un’infrastruttura performante, mentre valori superiori al secondo possono indicare problemi legati a configurazioni inefficienti o server sovraccarichi. -

Prestazioni desktop vs mobile

HostingAnalyzer confronta le performance del sito su desktop e dispositivi mobili, evidenziando eventuali differenze significative. Questa analisi è essenziale perché molti siti risultano veloci da PC ma lenti da smartphone, compromettendo l’esperienza utente. -

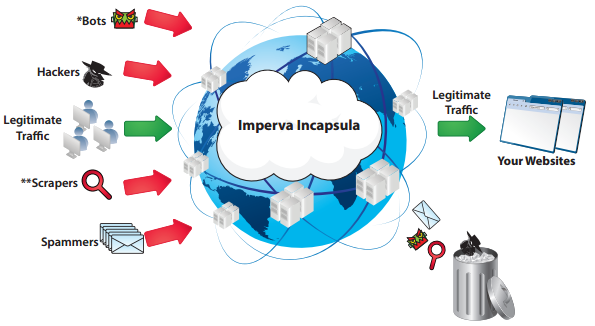

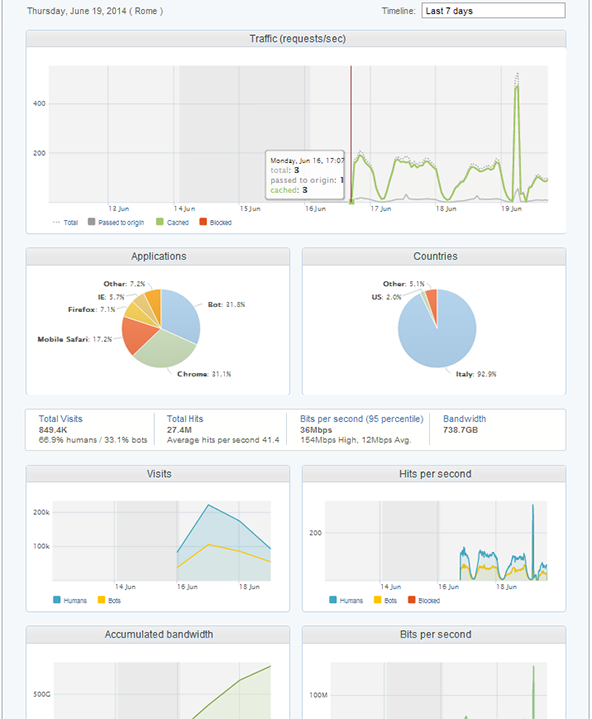

Analisi della CDN

Il software individua automaticamente l’eventuale utilizzo di una Content Delivery Network (CDN) e ne verifica l’efficacia. Non basta infatti avere una CDN attiva: è fondamentale che sia configurata correttamente per migliorare la distribuzione dei contenuti. -

Analisi SSL/TLS e geolocalizzazione

HostingAnalyzer controlla l’adozione dei protocolli di sicurezza più recenti, come TLS 1.3, e determina la posizione geografica del server. La distanza fisica tra server e utente, infatti, può influire in modo significativo sui tempi di caricamento.

Grazie a queste analisi, HostingAnalyzer fornisce una valutazione oggettiva dell’infrastruttura di hosting, aiutando l’utente a prendere decisioni più consapevoli.

A chi è rivolto

Il software è stato progettato per essere versatile e adattarsi alle esigenze di diversi profili:

-

Sviluppatori e sistemisti

Grazie ai dati dettagliati, HostingAnalyzer permette di individuare rapidamente eventuali criticità tecniche e ottimizzare la configurazione del server. -

Agenzie digitali

Consente di eseguire audit rapidi per siti dei clienti, confrontare fornitori di hosting e proporre soluzioni basate su dati concreti. -

Professionisti SEO

Le prestazioni di un sito sono uno dei fattori più importanti per il posizionamento sui motori di ricerca. HostingAnalyzer fornisce metriche fondamentali per intervenire laddove necessario e migliorare il ranking organico. -

Aziende e proprietari di siti

Anche chi non ha competenze tecniche può trarre vantaggio dallo strumento: il report generato è chiaro e facilmente comprensibile, rendendo semplice identificare i problemi e discuterne con il proprio provider di hosting.

I vantaggi di HostingAnalyzer.it

L’utilizzo del software sviluppato da Managed Server S.r.l. offre diversi benefici:

-

Trasparenza totale

I risultati forniti si basano su misurazioni reali, non su stime o dati “di marketing”. -

Analisi completa in pochi secondi

Con un solo test si ottiene un quadro chiaro dello stato delle performance e della qualità dell’infrastruttura. -

Strumento sempre aggiornato

HostingAnalyzer viene costantemente ottimizzato per tenere il passo con le evoluzioni tecnologiche del web, dai nuovi protocolli ai più recenti standard di sicurezza. -

Supporto per tutti i principali CMS e piattaforme e-commerce

Che si tratti di WordPress, PrestaShop, Magento, Drupal o WooCommerce, il test è valido per qualsiasi tipologia di sito.

L’esperienza di Managed Server S.r.l. al servizio della community

Lo sviluppo di HostingAnalyzer.it rappresenta l’evoluzione naturale dell’esperienza maturata da Managed Server S.r.l. negli anni.

L’azienda è specializzata in soluzioni di hosting ottimizzate per CMS, e-commerce e progetti web complessi, con un focus particolare sulle performance, la sicurezza e l’affidabilità delle infrastrutture.

Grazie alla conoscenza diretta delle problematiche più comuni riscontrate dai clienti, il team di Managed Server ha potuto progettare un software che risponde a esigenze concrete, offrendo un approccio data-driven alla valutazione della qualità dei servizi di hosting.

Un passo avanti verso un web più veloce

In un contesto digitale in cui la velocità è un fattore critico, HostingAnalyzer.it si propone come uno strumento indispensabile per chiunque voglia offrire un’esperienza utente di alto livello.

La lentezza di un sito non incide solo sulla soddisfazione dei visitatori, ma ha un impatto diretto sulle conversioni, sul posizionamento nei motori di ricerca e, di conseguenza, sul successo di un progetto online.

Con HostingAnalyzer, gli utenti possono finalmente basare le proprie decisioni su dati oggettivi e misurabili, evitando di affidarsi esclusivamente a promesse pubblicitarie.

Conclusioni

HostingAnalyzer.it è il risultato della continua ricerca e innovazione di Managed Server S.r.l. nel settore dell’hosting e delle performance web.

Grazie a questo software in cloud, chiunque può ottenere un’analisi chiara, approfondita e affidabile del proprio sito e della qualità del proprio hosting, senza bisogno di competenze avanzate o strumenti complessi.

Per Managed Server, si tratta di un ulteriore passo verso la diffusione della cultura delle performance e la creazione di un web più veloce, sicuro e accessibile.